Contexte historique

Bien avant la création des premiers ordinateurs, l’idée qu’une machine puisse agir comme un humain fascine plusieurs penseurs partout dans le monde. Ces créatures mythiques comprennent notamment le personnage grec Talos, un guerrier géant fait de bronze destiné à être le gardien de l’île de Crête. Une légende chinoise raconte quant à elle l’histoire d’un homme mécanique conçu par l’ingénieur Yan Shi qui aurait été présenté au roi de la dynastie Zhou au 10e siècle avant notre ère. Au cœur de la mythologie juive existe le Golem, une créature d’argile pouvant exécuter les ordres de son créateur à l’aide de sortilèges. Plus généralement, l’animisme, soit la croyance que les objets et les êtres vivants non humains possèdent un esprit animé et peuvent interagir avec l’intellect humain, est un élément important de plusieurs religions du monde, y compris les pratiques spirituelles des peuples autochtones de l’Amérique du Nord. Ces contextes culturels forment les assises de la fascination de l’Homme pour la création d’une intelligence artificielle.

Depuis les débuts des techniques de travail de précision des métaux, plusieurs sociétés du monde entier ont développé des automates, c’est-à-dire des appareils mécaniques capables d’imiter partiellement le comportement humain. En 807, Haroun al-Rashid, le calife abbasside de Bagdad, envoie en cadeau à Charlemagne, Empereur des Romains, une horloge mécanique spectaculaire agrémentée de 12 cavaliers mécaniques. Dans le Livre de la connaissance des procédés mécaniques (vers l’an 1206), l’ingénieur mécanique turc al-Jazari décrit des plans pour créer un orchestre mécanique animé par la pression hydraulique.

La Renaissance européenne voit quant à elle naître un chevalier mécanique en armure des mains de l’inventeur et humaniste italien Léonard De Vinci (1452-1519) ainsi que plusieurs figurines mécaniques installées dans des horloges d’églises de certaines villes allemandes, comme Nuremberg. Au tournant du 18e siècle, les artisans français et suisses produisent des automates pouvant encore être observés aujourd’hui dans des musées. Parmi ceux-ci un garçon mécanique de la taille d’une poupée pouvant écrire avec de l’encre, créé par l’horloger suisse Pierre Jaquet-Droz, et une œuvre du Français Jacques de Vaucanson, le Canard Digérateur, qui présente un oiseau mécanique fascinant les foules par le fait qu’il puisse ingérer de la vraie nourriture et, semblerait-il, l’expulser par la suite. Les colons français et anglais sont à l’origine de l’arrivée des automates au Canada. Par exemple, une poupée mécanique du 19e siècle conçue par l’artisan Léopold Lambert fait partie de la collection du musée McCord de Montréal.

Premières utilisations de l’électronique dans les recherches sur l’IA

Bien que les automates mécaniques puissent reproduire certains comportements humains, leur « intelligence », soit leur habileté à atteindre des objectifs complexes et modifiables dans un contexte social, s’avère simpliste et unidimensionnelle. Cependant, avec le développement des ordinateurs numériques électroniques dans les années 1930 et 1940, les scientifiques commencent à croire que les appareils de calcul peuvent être conçus de manière à adopter un comportement intelligent en reproduisant le fonctionnement du cerveau humain.

Les pionniers de l’informatique, tel le Britannique Alan Turing, sont fascinés par la manière dont les machines numériques se rapprochent et se différencient du cerveau humain et par la façon dont elles peuvent être programmées pour penser (et peut-être même ressentir) comme les humains. En 1943, les Américains Warren S. McCulloch, spécialiste des neurosciences, et Walter Pitts, logicien, mettent sur pied une théorie pour concevoir un « neurone artificiel », ce qui représente l’une des premières tentatives d’imiter le fonctionnement du cerveau humain à l’aide de charges électriques.

À la fin de la Deuxième Guerre mondiale, les ordinateurs électroniques deviennent plus facilement accessibles aux chercheurs universitaires, gouvernementaux et militaires, qui commencent à les programmer pour accomplir des tâches autrefois considérées comme exclusives à l’esprit humain. Ces tâches comprennent entre autres la résolution de problèmes mathématiques complexes et la compréhension de phrases dans certaines langues comme l’anglais, le français et le russe.

Le saviez-vous?

Les échecs font partie des activités ayant le plus piqué l’intérêt des chercheurs en IA. Ceux-ci commencent à créer des logiciels de jeu d’échecs dès les années 1940. L’idée d’automates pouvant jouer aux échecs est introduite au 18e siècle, alors qu’un « Turc mécanique » fait la tournée des cours royales d’Europe et impressionne les curieux grâce à sa prétendue habileté à jouer aux échecs. Le Turc mécanique s’avère finalement être une supercherie (un opérateur humain s’était glissé à l’intérieur du mécanisme), mais les échecs demeurent toutefois un défi logique évident pour alimenter la recherche en IA. La défaite du champion d’échec mondial Gary Kasparov par l’ordinateur Deep Blue d’IBM en 1997 représente d’ailleurs un moment clé de la recherche en IA.

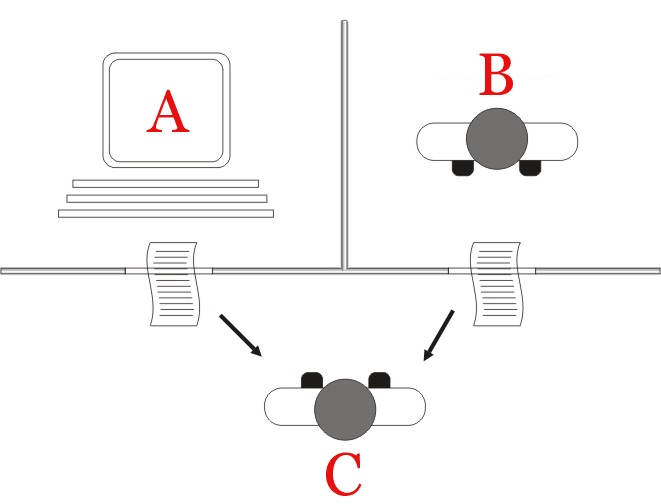

En 1950, Alan Turing conçoit ce qu’il nomme le « Jeu d’imitation », aujourd’hui mieux connu sous le nom de « Test de Turing ». Le mathématicien propose d’abord un scénario où un interrogateur humain assis dans une pièce doit deviner lequel des deux individus assis dans une autre pièce est un homme et lequel est une femme, selon leurs réponses écrites. Il propose ensuite d’échanger l’homme par un ordinateur. « L’interrogateur se trompera-t-il aussi souvent avec cette version du jeu que lorsque les candidats sont un homme et une femme? », se demande Alan Turing. Dans ce cas, déclare-t-il, une machine pourrait être considérée comme pensante.

Le Test de Turing est aujourd’hui simplifié et réfère à la capacité d’un ordinateur de faire croire à un humain, avec un grand pourcentage de réussite, qu’il est lui aussi humain. Cependant, la formule originale du cryptologue relève le fait que les genres et les autres formes d’identité humaine peuvent remettre en question la compréhension simpliste et uniforme de l’intelligence humaine.

Naissance du domaine de l’IA

L’intelligence artificielle se forme en tant que sous-domaine de l’informatique, de la science cognitive et de l’ingénierie au début des années 1950. Un événement clé de son développement se déroule au Dartmouth College, au New Hampshire, lors de l’été 1956. Un grand nombre de chercheurs universitaires d’établissements américains – y compris Marvin Minsky de Harvard, Allen Newell et Herbert Simon du Carnegie Institute of Technology, Claude Shannon de Bell Labs et John McCarthy de Dartmouth – s’y réunissent pendant deux mois pour « découvrir comment faire pour que les machines utilisent la langue, les formes, les abstractions et les concepts, résolvent des types de problèmes réservés à l’intellect humain et s’améliorent elles-mêmes. » Selon John McCarthy, les premières recherches en IA se concentrent surtout sur la manière de « considérer l’ordinateur comme un outil pour résoudre certains types de problèmes ». L’IA est donc « créée comme un sous-domaine de l’informatique et non de la psychologie », ce qui module intrinsèquement l’évolution du domaine, soit indépendamment des sciences sociales.

Un vif débat académique se concentre sur la question visant à savoir si l’intelligence artificielle devrait être comparée à l’intelligence humaine et, si oui, sur les méthodes appropriées pour le faire. Ce débat est également à la base d’une division conceptuelle plutôt importante dans la recherche, soit celle qui distingue l’IA forte de l’IA faible. L’intelligence artificielle forte fait référence à un système ayant des habiletés cognitives équivalentes ou supérieures à celles des humains, tandis que l’intelligence artificielle faible représente une machine capable d’accomplir des tâches précises inspirées des connaissances humaines.

Les chercheurs des années 1950 et 1960 commencent à se pencher sur la traduction automatique, l’apprentissage automatique et l’approche de la logique symbolique en IA. Les débuts des recherches dans le domaine tendent à se concentrer autour de deux approches. La première est celle du développement de langages de programmation symboliques généraux pouvant comprendre des commandes écrites dans des langues humaines, comme l’anglais. La deuxième consiste à encoder de grandes quantités de connaissances spécialisées et à utiliser les machines pour en tirer des conclusions pertinentes. Les limites techniques des ordinateurs de l’époque mettent cependant au défi les premiers chercheurs : les méthodes de la recherche exhaustive et de l’apprentissage statistique accomplissent des tâches beaucoup moins rapidement que l’humain moyen.

De l’âge d’or à « l’hiver de l’IA »

Malgré de grandes ambitions et des succès initiaux plutôt impressionnants, le principal résultat concret des débuts de la recherche en IA consiste à développer des outils informatiques de base. Ces outils, aujourd’hui souvent tenus pour acquis, incluent notamment les langages de programmation de traitement de listes, comme LISP (inventé par McCarthy entre 1956 et 1958 et encore utilisé aujourd’hui), et le partage de temps (qui permet à plusieurs personnes d’utiliser les capacités de traitement d’un ordinateur au même moment).

Étant donné leur héritage bilingue, les Canadiens ont une riche histoire en recherche sur la traduction automatique. Au milieu des années 1970, un groupe de l’Université de Montréal conçoit ce qui est alors le seul système de traduction entièrement automatique et de grande qualité utilisé quotidiennement. Connu sous le nom de système MÉTÉO, le logiciel traduit les prévisions météorologiques, présentées selon une formule préétablie, du Centre météorologique canadien, situé à Dorval, une banlieue de Montréal. Un système bien plus sophistiqué est plus tard conçu par le même groupe pour la traduction de manuels d’entretien d’avions. Même si la qualité de la traduction est considérée comme plutôt élevée, le financement gouvernemental pour le deuxième projet cesse en 1981; les coûts liés à la révision des traductions du système et à la mise à jour de son dictionnaire rendent son utilisation déficitaire. Le système MÉTÉO est cependant utilisé jusqu’en 2001.

En 1973, la Société canadienne pour l’étude de l’intelligence par ordinateur (aujourd’hui nommée l’Association pour l’intelligence artificielle au Canada) est fondée à l’Université de Western Ontario (aujourd’hui l’Université Western) par des chercheurs issus de partout au pays.

Les années 1970 voient également la première utilisation commerciale de machines pouvant réfléchir en fonction d’une base de données compilée par des experts humains. De tels « systèmes d’expert » sont utilisés pour soutenir le développement de domaines d’expertise plutôt précis, y compris les diagnostics médicaux avancés, les analyses chimiques, la conception de circuits électriques et la prospection de minéraux. Entre autres, l’expert minier canadien Alan Campbell participe à la conception d’un système de prospection d’IA plutôt connu, PROSPECTOR, à l’Université Stanford, en Californie.

D’autres logiciels d’IA émergent également dans les années 1970. Parmi ceux-ci, certains peuvent « comprendre » de façon limitée des langues écrites et parlées, tandis que d’autres peuvent inspecter les composantes, tels les pièces de fonte et les microcircuits intégrés d’une chaîne de montage.

Le succès mitigé des traductions automatiques lors de cette période est cependant décevant pour les agences de financement gouvernementales. Les coûts élevés et les minces possibilités d’appliquer concrètement l’IA sont à des années-lumière de ce qu’avaient prévu avec optimisme plusieurs chercheurs. Au milieu des années 1970, le premier « hiver de l’IA » s’installe donc, alors que les gouvernements nord-américains et européens réduisent leur financement à l’endroit de la recherche sur l’intelligence artificielle.

Les années 1980 et la « cinquième génération » de l’informatique

Au début des années 1980, le Japon, suivi de près par le Royaume-Uni et la Communauté économique européenne, annonce l’arrivée d’importants programmes nationaux visant à développer des systèmes informatiques d’IA souvent considérés comme de « cinquième génération ». Le gouvernement japonais les déclare alors comme une étape importante dans le raffinement technologique, qui implique de surpasser les ordinateurs à microprocesseurs conçus à la fin des années 1970. Ces systèmes informatiques se basent alors sur le modèle d’encodage spécialisé de connaissances et sur le traitement parallèle, soit l’utilisation simultanée de plusieurs processeurs pour analyser des données à grande échelle. De telles améliorations matérielles et logicielles en informatique mènent les chercheurs à prédire des avancées importantes en IA.

Emportés par l’enthousiasme généré par l’informatique de cinquième génération, de nombreux groupes privés et gouvernementaux commencent à reconnaître l’importance de la recherche en IA pour l’avenir du Canada et la nécessité de soutenir la recherche universitaire et industrielle dans le domaine. L’Institut canadien de recherches avancées (CIFAR) est ainsi fondé en 1982 pour faire la promotion de recherches révolutionnaires dans certains domaines ayant une importance stratégique. L’IA et la robotique sont alors sélectionnées comme premier point d’intérêt et, en 1983, le CIFAR lance le programme IA, robotique et société. Des groupes de recherche spécialisés en IA sont à ce moment-là déjà actifs dans plusieurs provinces (notamment en Alberta, en Colombie-Britannique, en Ontario et au Québec).

À la fin des années 1980, un groupe de quelques douzaines d’entreprises canadiennes forment Precarn Associates, un consortium visant à promouvoir la recherche appliquée à long terme en technologie d’IA. En facilitant la collaboration entre les chercheurs industriels, gouvernementaux et universitaires, le groupe contribue au développement de nouvelles utilisations commerciales de l’IA et permet aux entreprises canadiennes de devenir concurrentielles sur le marché international. Le regroupement Precarn comprend non seulement de petites entreprises de haute technologie, mais inclut également de grandes sociétés sidérurgiques et minières ainsi que des services publics. Le groupe est renommé Precarn Incorporated en 2001. Au milieu des années 2000, sous le gouvernement conservateur du premier ministre Stephen Harper, le consortium fait face à des restrictions en matière de financement, ce qui le mène finalement vers sa dissolution. Precarn cesse ses activités en 2011.

À la fin des années 1980, les ordinateurs de bureau utilisant des puces microprocesseur de quatrième génération, qui proviennent d’entreprises comme Intel, deviennent plus puissants et plus utiles dans un contexte quotidien. Cette amélioration cause l’effondrement du marché des ordinateurs spécialisés de cinquième génération conçus en fonction des systèmes d’IA. C’est alors le deuxième « hiver de l’IA », et le financement gouvernemental pour la recherche en intelligence artificielle est encore une fois coupé.

Années 1990 et 2000 : essor de l’apprentissage automatique et de l’apprentissage profond

Malgré les restrictions budgétaires de la fin des années 1980, les recherches en IA se poursuivent dans les établissements universitaires. Dans les années 1990, la recherche s’intensifie particulièrement dans le sous-domaine de l’apprentissage automatique, un mode d’apprentissage qui se base sur l’analyse statistique de grandes quantités de données pour entraîner les systèmes numériques à accomplir des tâches précises. De telles tâches incluent la reconnaissance d’images de chats parmi un ensemble ou l’identification et la compréhension de mots dans une langue humaine précise (processus connu sous le nom de traitement automatique des langues naturelles, ou TALN). Grâce à la quantité grandissante de données numériques disponibles depuis l’introduction d’Internet dans la vie quotidienne des gens, l’apprentissage automatique devient rapidement un sous-domaine majeur de la recherche en IA.

La traduction automatique (TA) est l’un des sous-domaines de l’apprentissage automatique et du TALN ayant toujours profité de l’expertise canadienne. En 1992, une importante conférence portant sur la TA, à Montréal, est la scène d’un vif débat opposant deux visions de la recherche dans le domaine : les « rationnels » se basent sur les théories linguistiques pour structurer la traduction automatique, tandis que les « empiriques » utilisent le traitement statistique à grande échelle d’énormes quantités de données. La recherche menée par IBM, qui adopte l’approche empirique, se base sur les dossiers parlementaires bilingues du Canada, le Hansard, pour appuyer ses projets en traduction.

Les universités canadiennes investissent rapidement dans la recherche en apprentissage automatique, et ce, en partie grâce au soutien constant que le CIFAR apporte au domaine. En 1987, l’Université de Toronto embauche le Britannique Geoffrey E. Hinton, un pionnier de l’apprentissage profond (l’utilisation de réseaux de neurones artificiels pour analyser des données). En 1993, l’Université de Montréal embauche à son tour un chercheur en apprentissage automatique, Yoshua Bengio, détenteur d’un doctorat de l’Université McGill depuis deux ans. Finalement, en 2003, l’ Université de l’Alberta engage l’Américain Rich Sutton, un pionnier de l’apprentissage par renforcement.

En 2004, le CIFAR, alors sous la direction de Geoffrey Hinton, participe à l’intensification des recherches universitaires en apprentissage profond grâce à son programme Calcul neuronal et perception adaptative. Le programme (aujourd’hui connu sous le nom d’Apprentissage automatique, apprentissage biologique) vise alors à raviver l’intérêt envers les réseaux de neurones en réunissant des spécialistes en informatique, en biologie, en neuroscience et en psychologie. Rich Sutton, Yoshua Bengio et Geoffrey Hinton, ainsi que plusieurs de leurs collègues et collaborateurs, sont des acteurs clés dans la création des conditions ayant mené le Canada à gagner de l’importance comme centre de recherche en IA.

Le saviez-vous?

Yoshua Bengio, Geoffrey Hinton et leur collègue informaticien Yann LeCun remportent le prix A.M. Turing 2018 pour leurs travaux de recherche novateurs sur les réseaux neuronaux profonds. Décerné par l’Association for Computing Machinery (ACM), le prix d’un million de dollars est reconnu comme le prix Nobel de l’informatique. L’ACM qualifie les travaux des trois hommes de fondement d’avancées rapides dans des domaines tels que la vision artificielle, la reconnaissance de la parole et le traitement du langage naturel. Dans le cadre d’entretiens qui suivent l’attribution du prix, tant Yoshua Bengio que Geoffrey Hinton mettent en garde contre l’usage de l’IA dans les systèmes d’armes, tout en appelant à un accord international pour limiter ces technologies de guerre.

De 2005 à aujourd’hui : le Canada prend les devants

Depuis 2005, un intérêt commercial et académique pour l’IA, aujourd’hui souvent synonyme d’apprentissage automatique, a refait surface partout dans le monde. Le Canada se situe aux devants de cette nouvelle vague d’enthousiasme pour l’IA, entre autres grâce à ses centres de recherche universitaires, notamment les universités de la Colombie-Britannique, de l’Alberta, de Waterloo, de Toronto, de Montréal et McGill. L’intégration que fait le Canada de talents intellectuels variés d’origines diverses joue également un grand rôle dans le succès qu’a le pays à attirer des investisseurs internationaux pour sa recherche en technologies d’IA.

En matière de recherche en IA, le Canada mise sur ses forces préexistantes. Dans son budget fédéral de 2017, le gouvernement libéral du premier ministre Justin Trudeau annonce l’attribution de 125 millions de dollars à la Stratégie pancanadienne en matière d’intelligence artificielle, un programme de cinq ans coordonné par le CIFAR. La Stratégie finance la création de trois nouveaux instituts d’IA : l’Alberta Machine Intelligence Institute (AMII) à Edmonton, le Vector Institute à Toronto et l’Institut des algorithmes d’apprentissage de Montréal (MILA). Elle vise également à soutenir une communauté nationale de recherche en IA, à augmenter le nombre de chercheurs en IA au Canada et à « établir un leadership éclairé d’envergure mondiale relativement aux répercussions économiques, éthiques, politiques et juridiques des percées en intelligence artificielle ». À l’approche du Sommet du G7 de Charlevoix en 2018, à Québec, Justin Trudeau et le président français, Emmanuel Macron, s’engagent à créer un groupe d’étude international portant sur l’IA intégrative et éthique. Le Canada organise également une conférence pour le G7 en décembre 2018 à propos de l’utilisation responsable de l’IA et de son application en affaires.

Entreprises canadiennes en IA

Les entreprises canadiennes travaillent de manière à transposer leur expertise et leur enthousiasme pour l’IA en modèles d’affaires solides. Maluuba, une entreprise fondée par des diplômés de l’Université de Waterloo en 2011, est un exemple de société ayant réussi un tel projet. Maluuba conçoit des systèmes d’IA capables de comprendre et d’interpréter les langues humaines naturelles. Dotée d’une équipe de recherche en apprentissage profond axée sur la compréhension des langues naturelles, l’entreprise basée à Montréal est achetée par Microsoft en 2017 et transformée en laboratoire de recherche de Microsoft (voir aussi Microsoft Canada Inc.).

Un autre exemple est celui de Borealis AI, un institut de recherche fondé par la Banque Royale du Canada en 2016. Borealis AI applique une technologie d’apprentissage automatique aux services financiers. Ses domaines d’intérêt sont notamment l’apprentissage par renforcement, le traitement du langage naturel et l’éthique en matière d’intelligence artificielle. L’institut a des bureaux à Toronto, Montréal, Vancouver et Waterloo.

Les jeunes entreprises canadiennes en IA situées à Montréal et à Toronto développent des applications allant du marketing conversationnel à la livraison de repas et à la vente en ligne. En janvier 2018, l’entreprise de télécommunications mobiles BlackBerry signe une entente avec Baidu, fournisseur chinois de serveurs de recherche, pour développer conjointement une technologie d’apprentissage automatique pour créer des voitures entièrement automatisées. D’autres sociétés informatiques mondiales comme Facebook, Google, Samsung et NVIDIA ont également ouvert des centres de recherche à Montréal et à Toronto. DeepMind, une division de Google, possède quant à elle des laboratoires de recherche à Edmonton et à Montréal.

Possibilités et défis liés à l’IA

L’intelligence artificielle a déjà un grand impact sur la vie quotidienne des Canadiens; les technologies d’IA sont de plus en plus intégrées dans les systèmes informatiques utilisés tant par les gouvernements que par les entreprises. La majeure partie du débat public à propos de l’IA (et de son marketing) fait référence à l’image d’« IA forte » véhiculée par les mythes, les légendes et la science-fiction. Cependant, les technologies appliquées d’IA comme l’apprentissage automatique et les agents intelligents (par exemple les robots de clavardage sur les pages Web de service à la clientèle ou les agents virtuels comme Siri, d’Apple, sur les téléphones intelligents) font déjà partie de la société canadienne. Ces technologies pourraient potentiellement être utilisées de manière positive dans des contextes commerciaux et gouvernementaux : un rapport de 2018 émis par le Conseil du Trésor du Canada souligne le potentiel qu’ont les technologies d’IA d’aider les Canadiens et les entreprises avec leurs transactions routinières grâce à des agents de service virtuels, de faire le suivi d’industries pour déceler des signes précurseurs de non-conformité aux processus réglementaires et de moduler les politiques gouvernementales en offrant une nouvelle perspective lors de l’analyse des données.

Toutefois, les technologies d’IA posent également bon nombre de défis pour la société canadienne. Un des principaux soucis est celui de la perte potentielle d’emplois engendrée par une nouvelle vague d’automatisation des tâches des « cols blancs ». Une autre inquiétude est la possibilité que les systèmes d’apprentissage automatique, dans des domaines comme la justice pénale, renforcent divers préjugés raciaux et discriminatoires. Les techniques telles que l’apprentissage automatique se basent sur de grandes quantités de données numériques mondiales, et il s’avère difficile d’éviter de transférer et d’amplifier le racisme, le sexisme et d’autres préjugés présents dans les données des systèmes informatiques d’IA.

Dans le même ordre d’idées, les technologies d’IA se basant sur de grandes quantités de données numériques soulèvent de grandes inquiétudes par rapport à la vie privée; elles pourraient permettre à de grandes institutions de présumer des choses à propos des Canadiens en fonction de détails personnels qu’ils préféreraient ne pas partager. Des présomptions par rapport à la santé d’une personne pourraient par exemple augmenter son tarif d’assurance, tandis que des présuppositions par rapport à son comportement pourraient jouer contre elle en cas de procès. Même les systèmes d’apprentissage automatique les mieux conçus sont à risque de créer des inégalités ou de la discrimination, s’ils sont utilisés dans un contexte injuste, et d’agir de manière à renforcer ou à amplifier les inégalités sociales.

Le saviez-vous?

Certaines unités de la Gendarmerie royale du Canada (GRC) ont utilisé un logiciel de reconnaissance faciale appelé Clearview AI pour enquêter sur des crimes. Clearview AI a été conçu pour trouver des détails sur une personne sur une photo en balayant une base de données de milliards d’images collectées sur les médias sociaux et d’autres sites. Avant que la liste des clients de Clearview AI ne soit piratée et divulguée aux médias au début de l’année 2020, la GRC avait nié avoir utilisé la reconnaissance faciale. D’autres forces policières au Canada ont également admis avoir utilisé le logiciel à la suite de la fuite. Dans un souci de respect de la vie privée, la GRC a déclaré qu’elle n’utiliserait le logiciel que dans des cas urgents, comme l’identification de victimes d’abus sexuels sur des enfants. La GRC a cessé d’utiliser Clearview AI lorsque l’entreprise a cessé ses activités au Canada en juillet 2020. Un rapport publié en juin 2021 par le Commissariat à la protection de la vie privée (CPVP) a conclu que la GRC avait enfreint la Loi sur la protection des renseignements personnels en utilisant Clearview AI.

Les entreprises de technologie numérique canadiennes, y compris celles travaillant en IA, ont énormément de travail à accomplir pour améliorer la diversité de genres et d’ethnies dans leur milieu de travail. Elles doivent également travailler plus pour intégrer les membres de la société mal desservis par la technologie. Plusieurs Canadiens, y compris les peuples autochtones de plusieurs régions rurales et de communautés isolées, ont un accès limité aux technologies numériques. (Voir aussi : Informatique et société; Société d’information.)

Développement responsable de l’IA

Avec le déploiement croissant des technologies d’IA par les entreprises et les gouvernements, des membres inquiets de groupes de la société civile, d’associations professionnelles et même des sociétés informatiques elles-mêmes, se soucient de l’éthique reliée à l’utilisation de telles technologies et à leur développement. En 2017, un groupe basé à l’Université de Montréal dépose une première version de la Déclaration de Montréal pour un développement responsable de l’intelligence artificielle, qui trace les grandes lignes du développement de l’IA dans l’intérêt de l’humanité. Le document déclare que l’IA doit ultimement promouvoir le bien-être de tous les êtres sensibles, la participation éclairée à la vie publique et les débats démocratiques.

Les Canadiens doivent prendre part à des discussions nationales difficiles, mais potentiellement bénéfiques, par rapport au rôle des technologies d’IA dans différents secteurs et à la manière dont elles peuvent améliorer le tissu social canadien. Un des points importants de la Stratégie pancanadienne en matière d’intelligence artificielle du CIFAR est l’étude des effets de l’IA sur la société canadienne. Les sociologues, les anthropologues, les avocats, les économistes et les historiens, en collaboration avec les informaticiens et les ingénieurs, ont tous un rôle à jouer pour arriver à cerner ces conséquences. Les Canadiens, influencés quotidiennement par ces technologies, ont eux aussi cette responsabilité.

Partager sur Facebook

Partager sur Facebook Partager sur X

Partager sur X Partager par Email

Partager par Email Partager sur Google Classroom

Partager sur Google Classroom